Acercándonos al LHC

El CERN opera algunas de las máquinas científicas más complejas jamás construidas, que dependen de intrincados sistemas de control y generan petabytes y petabytes de datos de investigación. Tanto el funcionamiento de estos equipos como el análisis de los datos recopilados son tareas intensivas. Por ello, el CERN recurre cada vez más a la investigación en el campo de la inteligencia artificial (IA) para hacer frente a algunos de los retos que plantean el manejo de datos, la manipulación de haces de partículas y el mantenimiento de sus instalaciones.

El concepto moderno de inteligencia artificial surgió más o menos al mismo tiempo que el CERN, a mediados de los años cincuenta. Tiene distintos significados según el contexto, y el CERN se interesa principalmente por la llamada IA restringida, orientada a tareas, más que por la IA general, que incluye aspectos como la resolución independiente de problemas o incluso la conciencia artificial. Los físicos de partículas fueron uno de los primeros grupos en utilizar técnicas de IA en su trabajo, adoptando el aprendizaje automático (Machine Learning, ML) ya en 1990. Más allá del ML, los físicos del CERN también están interesados en el uso del aprendizaje profundo para analizar la avalancha de datos del LHC.

Como ya hemos indicado, las partículas que colisionan en los aceleradores producen numerosas cascadas de partículas secundarias. La electrónica que procesa las señales que llegan en avalancha desde los detectores tiene entonces una fracción de segundo para evaluar si un evento es lo suficientemente interesante como para guardarlo para un análisis posterior. En el futuro próximo, esta exigente tarea podrá llevarse a cabo mediante algoritmos basados en IA.

Por ello, han recurrido a un subdominio de la IA, denominado aprendizaje automático (machine learning, ML), para mejorar la eficiencia y eficacia de estas tareas. De hecho, las cuatro principales colaboraciones del LHC, ALICE, ATLAS, CMS y LHCb, han formado el Grupo de Trabajo Interexperimental de Aprendizaje Automático (IML) para seguir las tendencias de desarrollo en ML. Los investigadores también están colaborando con la comunidad más amplia de la ciencia de datos para organizar talleres para formar a la próxima generación de científicos en el uso de estas herramientas, y para producir investigación original en Aprendizaje Profundo. ROOT, el programa de software desarrollado por el CERN y utilizado por físicos de todo el mundo para analizar sus datos, también incluye bibliotecas de aprendizaje automático.

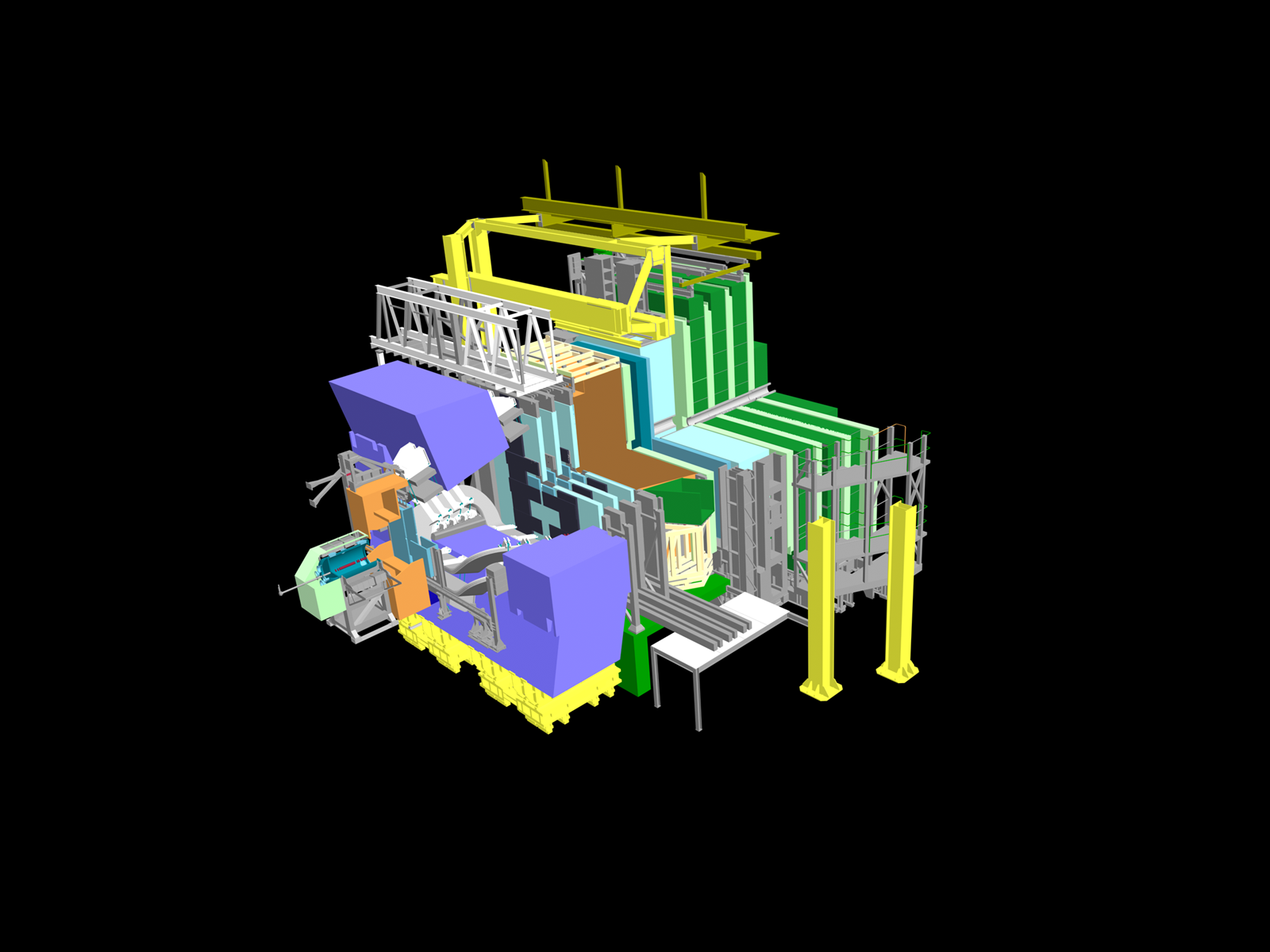

Un ejemplo concreto de como puede ser usada la IA la encontramos en el detector CMS, en relación a la búsqueda de nueva física que vaya más allá del Modelo Estándar.

Aunque las técnicas de aprendizaje automático (ML) se utilizan en la física de partículas desde la década de 1980, y en el CMS desde su nacimiento, éstas se han basado tradicionalmente en las entradas altamente procesadas producidas por algoritmos de reconstrucción en lugar de en los datos "en bruto" más básicos proporcionados por los detectores de partículas. Este paradigma de análisis de datos fue decisivo en varios análisis de física del CMS, incluyendo algunos descubrimientos interesantes, pero no fue lo suficientemente bueno como para superar los retos planteados por muchas desintegraciones exóticas. De hecho, el factor limitante no era tanto el rendimiento de los algoritmos de ML en sí, sino el de los algoritmos utilizados para convertir los datos brutos de los detectores en observables de física básica.

Aquí entran en juego la inteligencia artificial (IA) moderna y el “deep learning”. Gracias a esta nueva generación de algoritmos de ML, ahora es posible evitar el paso de reconstrucción convencional y procesar directamente los datos del detector. La aplicación de la IA para extraer directamente información sobre partículas a partir de datos de detector de bajo nivel (un nuevo enfoque a menudo denominado reconstrucción de partículas de extremo a extremo) promete desvelar posibles vías de información que podrían resolver algunos de los mayores retos a los que nos enfrentamos en la búsqueda de desintegraciones exóticas.

Uso de técnicas de aprendizaje automático para buscar colisiones de aspecto exótico.

Uno de los principales objetivos de los experimentos del LHC es buscar indicios de nuevas partículas, que podrían explicar muchos misterios sin resolver de la física. A menudo, las búsquedas de nueva física se diseñan para buscar un tipo específico de nueva partícula a la vez, basándose en predicciones teóricas. Pero, ¿qué ocurre con la búsqueda de partículas imprevistas e inesperadas?

Pasar por los miles de millones de colisiones que tienen lugar en los experimentos del LHC sin saber exactamente qué buscar sería una tarea colosal para los físicos. Por eso, en lugar de cribar los datos y buscar anomalías, las colaboraciones ATLAS y CMS están dejando que la inteligencia artificial (IA) haga el trabajo.

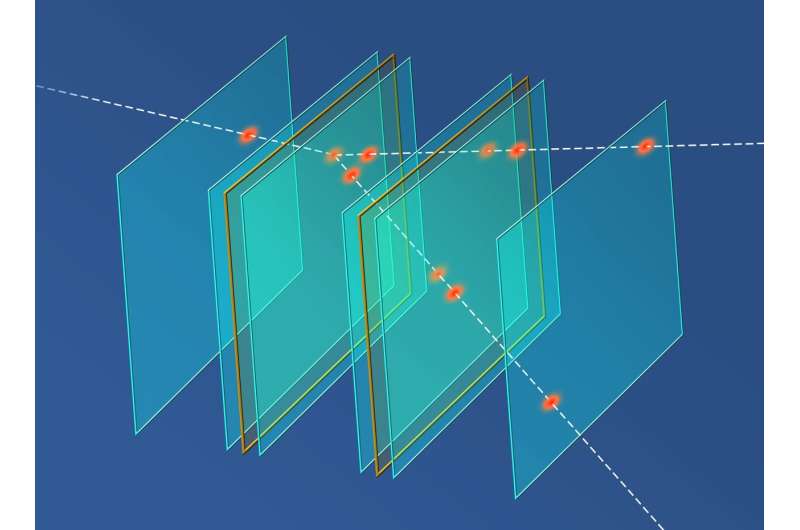

Los investigadores de estas dos colaboraciones utilizan diversas estrategias para entrenar a los algoritmos de IA en la búsqueda de jets. Estudiando la forma de sus complejas firmas energéticas, los científicos pueden determinar qué partícula creó el chorro.

Producción en colisiones pp de una resonancia di-jet, A, que decae en dos resonancias B y C, que a su vez decaen en un jet con una subestructura anómala que surge de múltiples sub-jets.

Otro método consiste en pedir al algoritmo de IA que examine toda la colisión y busque características anormales en las distintas partículas detectadas. Estas características anómalas pueden indicar la presencia de nuevas partículas.

Otro procedimiento implica que los físicos creen ejemplos simulados de posibles señales nuevas y, a continuación, pidan a la IA que identifique colisiones en los datos reales que sean diferentes de los jets normales, pero que se parezcan a la simulación.

Ver más en:

https://atlas.cern/Updates/Briefing/Anomaly-Detection

https://cms-results.web.cern.ch/cms-results/public-results/preliminary-results/EXO-22-026/index.html

Otro ejemplo es una investigación presentada en Computer Science por científicos del Instituto de Física Nuclear de la Academia Polaca de Ciencias (IFJ PAN) en Cracovia (Polonia), que sugiere que herramientas construidas mediante inteligencia artificial (IA) podrían ser una alternativa eficaz a los métodos actuales para la reconstrucción rápida de huellas de partículas. Su debut podría producirse muy pronto, probablemente en el experimento MUonE del CERN, que apoya la búsqueda de nueva física.

|

AUTORES Xabier Cid Vidal, Doctor en Física de Partículas (experimental) por la Universidad de Santiago (USC). Research Fellow in experimental Particle Physics en el CERN, desde enero de 2013 a diciembre de 2015. Estuvo vinculado al Depto de Física de Partículas de la USC como becario "Juan de la Cierva", "Ramon y Cajal" (Spanish Postdoctoral Senior Grants), y Profesor Contratado Doctor. Desde 2023 es Profesor Titular de Universidad en ese Departamento (ORCID). Ramon Cid Manzano, catedrático de Fïsica y Química en el IES de SAR (Santiago - España), y Profesor Asociado en el Departamento de Didáctica de Ciencias Experimentales de la Facultad de Educación de la Universidad de Santiago (España), hasta su retiro en 2020. Es Licenciado en Física, Licenciado en Química, y Doctor por la Universidad de Santiago (USC).(ORCID). |

CERN |

LHC |

NOTA IMPORTANTE

Toda la Bibliografía que ha sido consultada para esta Sección está indicada en la Sección de Referencias

© Xabier Cid Vidal & Ramon Cid - rcid@lhc-closer.es | SANTIAGO (ESPAÑA) |