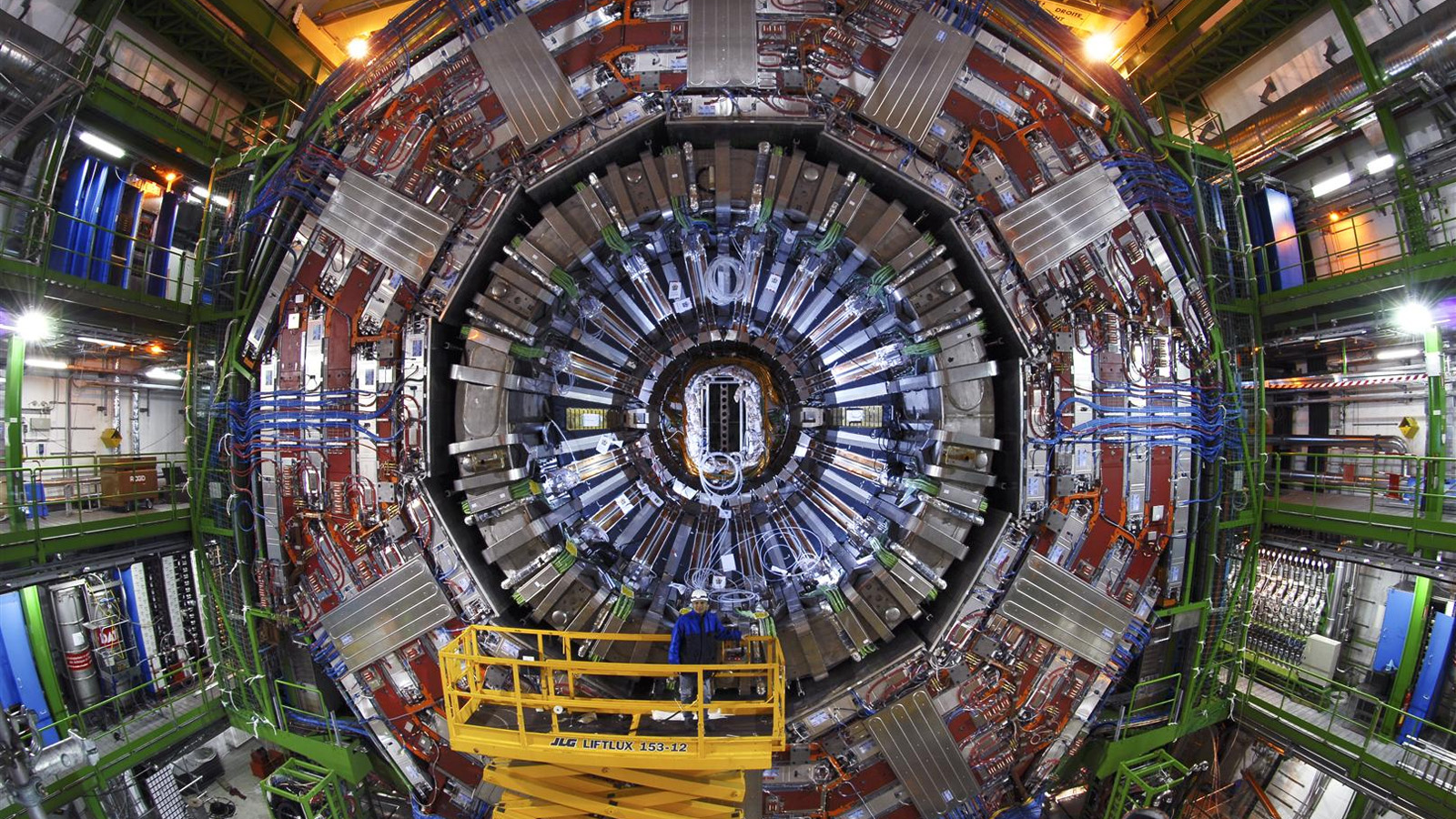

Achegándonos ao LHC

O CERN opera algunhas das máquinas científicas máis complexas xamais construídas, que dependen de intrincados sistemas de control e xeran petabytes e petabytes de datos de investigación. Tanto o funcionamento destes equipos como a análise dos datos recompilados son tarefas intensivas. Por iso, o CERN recorre cada vez máis á investigación no campo da intelixencia artificial (IA) para facer fronte a algúns dos retos que expoñen o manexo de datos, a manipulación de fas de partículas e o mantemento das súas instalacións.

O concepto moderno de intelixencia artificial xurdiu máis ou menos ao mesmo tempo que o CERN, a mediados dos anos cincuenta. Ten distintos significados segundo o contexto, e o CERN interésase principalmente pola chamada IA restrinxida, orientada a tarefas, máis que pola IA xeral, que inclúe aspectos como a resolución independente de problemas ou mesmo a conciencia artificial. Os físicos de partículas foron un dos primeiros grupos en utilizar técnicas de IA no seu traballo, adoptando a aprendizaxe automática (Machine Learning, ML) xa en 1990. Máis aló do ML, os físicos do CERN tamén están interesados no uso da aprendizaxe profunda para analizar a avalancha de datos do LHC.

Como xa indicamos, as partículas que chocan nos aceleradores producen numerosas fervenzas de partículas secundarias. A electrónica que procesa os sinais que chegan en avalancha desde os detectores ten entón unha fracción de segundo para avaliar se un evento é o suficientemente interesante como para gardalo para unha análise posterior. No futuro próximo, esta esixente tarefa poderá levar a cabo mediante algoritmos baseados en IA.

Por iso, recorreron a un subdominio da IA, denominado aprendizaxe automática (machine learning, ML), para mellorar a eficiencia e eficacia destas tarefas. De feito, as catro principais colaboracións do LHC, ALICE, ATLAS, CMS e LHCb, formaron o Grupo de Traballo Interexperimental de Aprendizaxe Automática (IML) para seguir as tendencias de desenvolvemento en ML. Os investigadores tamén están a colaborar coa comunidade máis ampla da ciencia de datos para organizar talleres para formar á próxima xeración de científicos no uso destas ferramentas, e para producir investigación orixinal en Aprendizaxe Profunda. ROOT, o programa de software desenvolvido polo CERN e utilizado por físicos de todo o mundo para analizar os seus datos, tamén inclúe bibliotecas de aprendizaxe automática.

Como xa indicamos, as partículas que coliden nos aceleradores producen numerosos chorros de partículas secundarias. A electrónica que procesa os sinais que chegan en avalancha desde os detectores ten entón unha fracción de segundo para avaliar se un evento é o suficientemente interesante como para gardalo para unha análise posterior. Nun futuro próximo, esta esixente tarefa poderá levarse a cabo mediante algoritmos baseados en IA.

Un exemplo concreto de como pode ser usada a IA atopámola no detector CMS, en relación á procura de nova física que vaia máis aló do Modelo Estándar. Aínda que as técnicas de aprendizaxe automática (ML) utilízanse na física de partículas desde a década de 1980, e no CMS desde o seu nacemento, estas baseáronse tradicionalmente nas entradas altamente procesadas producidas por algoritmos de reconstrución en lugar de en os datos "en bruto" máis básicos proporcionados polos detectores de partículas. Este paradigma de análise de datos foi decisivo en varias análises de física do CMS, incluíndo algúns descubrimentos interesantes, pero non foi o suficientemente bo como para superar os retos expostos por moitas desintegracións exóticas. De feito, o factor limitante non era tanto o rendemento dos algoritmos de ML en si, senón o dos algoritmos utilizados para converter os datos brutos dos detectores en observables de física básica.

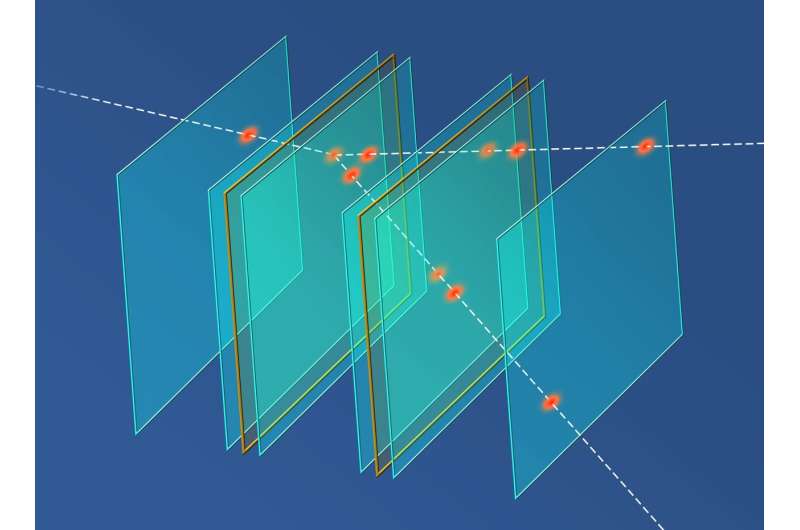

Aquí entran en xogo a intelixencia artificial (IA) moderna e o “deep learning”. Grazas a esta nova xeración de algoritmos de ML, agora é posible evitar o paso de reconstrución convencional e procesar directamente os datos do detector. A aplicación da IA para extraer directamente información sobre partículas a partir de datos de detector de baixo nivel (un novo enfoque a miúdo denominado reconstrución de partículas de extremo a extremo) promete desvelar posibles vías de información que poderían resolver algúns dos maiores retos aos que nos enfrontamos na procura de desintegracións exóticas.

Uso de técnicas de aprendizaxe automática para buscar colisións de aspecto exótico.

Un dos principais obxectivos dos experimentos do LHC é buscar indicios de novas partículas, que poderían explicar moitos dos misterios sen resolver da Física. A miúdo, as búsquedas de nova física se deseñan para buscar un tipo específico de nova partícula á vez, baseándose en predicións teóricas. Pero, qué ocorre coa búsqueda de partículas imprevistas e inesperadas?

Pasar por os centos de miles de millóns de colisións que teñen lugar nos experimentos do LHC sen saber exactamente qué buscar sería unha tarefa colosal para os físicos. Por iso, en lugar de peneirar os datos e buscar anomalías, as colaboraciones ATLAS e CMS están deixando que a intelixencia artificial (IA) faga o traballo.

Os investigadores destas dúas colaboraciónses utilizan diversas estratexias para entrenar aos algoritmos de IA na procura de jets. Estudando a forma da súas complexas signatiuras enerxéticas, os científicos poden determinar qué partícula creou o jet.

Produción en colisións pp dunha resonancia di-jet, A, que decae en dúas resonancias B e C, que a súa vez decaen nun jet cunha subestrutura anómala que xorde de múltiples sub-jets.

Outro método consiste en pedir ao algoritmo de IA que examine toda a colisión e busque características anormales nas distintas partículas detectadas. Estas características anómalas poden indicar a presenza de novas partículas.

Outro procedemento implica que os físicos creen exemplos simulados de posibles sinais novas e, deseguido, pidan á IA que identifique colisións nos datos reais que sexan diferentes dos jets normales, pero que se parezan á simulación.

Ver máis en:

https://atlas.cern/Updates/Briefing/Anomaly-Detection

https://cms-results.web.cern.ch/cms-results/public-results/preliminary-results/EXO-22-026/index.html

Outro exemplo é a investigación presentada en Computer Science por científicos do Instituto de Física Nuclear da Academia Polaca de Ciencias (IFJ PAN) en Cracovia (Polonia), que suxire que ferramentas construídas mediante intelixencia artificial (IA) poderían ser unha alternativa eficaz aos métodos actuais para a reconstrución rápida de pegadas de partículas. O seu debut podería producirse nos próximos dous ou tres anos, probablemente no experimento MUonE do CERN, que apoia a procura de nova física.

|

AUTORES Xabier Cid Vidal, Doctor en Física de Partículas (experimental) pola Universidad de Santiago (USC). Research Fellow in experimental Particle Physics no CERN, desde xaneiro de 2013 a decembroe de 2015. Estivo vencellado ao Depto de Física de Partículas da USC como becario "Juan de la Cierva", "Ramon y Cajal" (Spanish Postdoctoral Senior Grants), e Profesor Contratado Doutor. Desde 2023 é Profesor Titular de Universidade nese Departamento (ORCID). Ramon Cid Manzano, foi catedrático de Fïsica e Química no IES de SAR (Santiago - España), e Profesor Asociado no Departamento de Didáctica de Ciencias Experimentais da Facultade de Educación da Universidad de Santiago (España), ata o seu retiro en 2020. É licenciado en Física, licenciado en Química, e Doutor pola Universidad de Santiago (USC).(ORCID). |

CERN CERN Experimental Physics Department CERN and the Environment |

LHC |

NOTA IMPORTANTE

Toda a Bibliografía que foi consultada para esta Sección está indicada na Sección de Referencias

© Xabier Cid Vidal & Ramon Cid - rcid@lhc-closer.es | SANTIAGO |