Achegándonos ao LHC

O LHC produce arredor de 600 millións de collisións ( ~ 109 colisións) protón-protón en funcionamento nominal nos detectores ATLAS ou CMS. A cantidade de datos promedio por evento supón unha media de 1 MB (1 Megabyte).

109 colisións/s x 1 Mbyte/colisión = 1015 bytes/s = 1 PB/s (1 Petabyte/segundo)

Dado que 1 DVD ~ 5 GB : 200000 DVDs por segundo farían falta para almacenar eses datos, ouarredor de 6000 IPods (cada un con 160 GB de capacidade) por segundo!

Isto é varios ordes de magnitude máis grande do que calquera sistema de adquisición de datos dun detector actual pode manexar.

Un sistema trigger (disparo) tense deseñando para rexeitar os eventos non interesantes e manter só os interesantes (máis información sobre o trigger na seguinte páxina).

Por exemplo, o sistema trigger de ATLAS está deseñando para tratar uns 200 eventos por segundo.

200 eventos/s x 1 Mbyte = 200 MB/s (200 Megabyte/segundo)

Considerando dous turnos de 10 horas por día, e uns 300 días no ano:

200 MB/s x 2 x 10 x 3600 x 300 ~ 4·1015 bytes/ano= 4 PB/ano

En conxunto, os experimentos LHC producen arredor de 15 petabytes de datos en bruto por ano que deben ser almacenados, procesados e analizados.

Un sistema trigger de tres niveis é utilizado para seleccionar eventos que amosan signos de procesos físicos de interese.

- O nivel-1 é un trigger baseado en hardware que selecciona eventos con cantidades grande de enerxía depositadas nos calorímetros, ou sinais nas cámaras de muóns ...

- O nivel-2 está baseado en software, e selecciona eventos a partir da análise preliminar dos datos de interese identificadas polo nivel-1.

- O nivel-3 fai unha reconstrución inicial do evento completo, e se elecciona se é de interese. Entón é almacenado para análise posterior "offline".

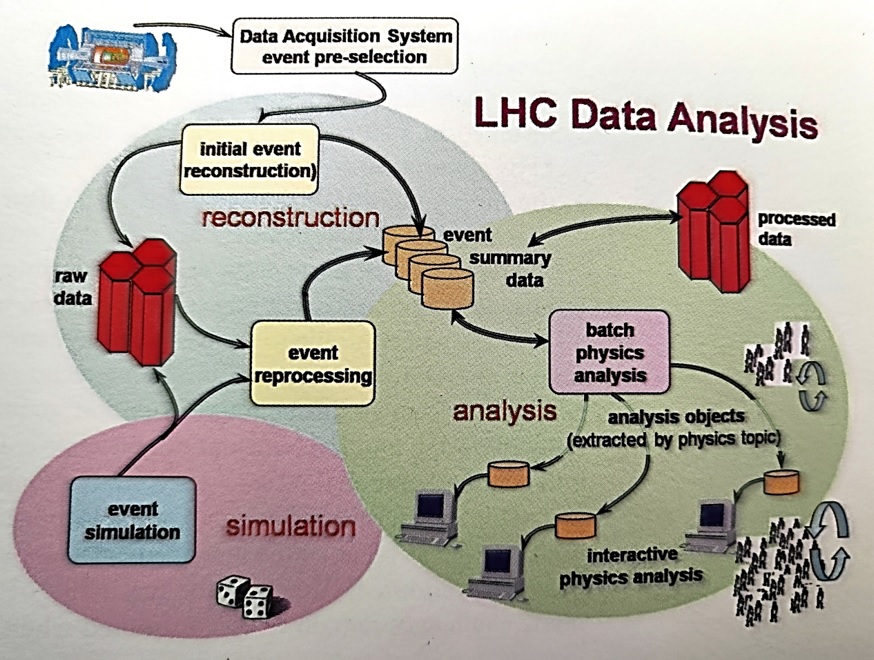

Para realizar estes procesos, aplícanse sucesivamente sofisticados algoritmos aos datos en bruto, para extraer información física e observables de interese que podan seren comparadas con predicións teóricas.

A seguinte figura (tomada do libro The Large Hadron Collider: a Marvel of Technology editado por Lyndon Evans) mostra un esquema dos fluxos de datos e as principais etapas dos procesos involucrados.

Para máis información ver EVANS L. (Ed). The Large Hadron Collider: a Marvel of Technology. CERN and EPFL Press (2009). Capítulo 5.6.

|

AUTORES Xabier Cid Vidal, Doctor en Física de Partículas (experimental) pola Universidad de Santiago (USC). Research Fellow in experimental Particle Physics no CERN, desde xaneiro de 2013 a decembroe de 2015. Estivo vencellado ao Depto de Física de Partículas da USC como becario "Juan de la Cierva", "Ramon y Cajal" (Spanish Postdoctoral Senior Grants), e Profesor Contratado Doutor. Desde 2023 é Profesor Titular de Universidade nese Departamento (ORCID). Ramon Cid Manzano, foi catedrático de Fïsica e Química no IES de SAR (Santiago - España), e Profesor Asociado no Departamento de Didáctica de Ciencias Experimentais da Facultade de Educación da Universidad de Santiago (España), ata o seu retiro en 2020. É licenciado en Física, licenciado en Química, e Doutor pola Universidad de Santiago (USC).(ORCID). |

CERN CERN Experimental Physics Department CERN and the Environment |

LHC |

NOTA IMPORTANTE

Toda a Bibliografía que foi consultada para esta Sección está indicada na Sección de Referencias

© Xabier Cid Vidal & Ramon Cid - rcid@lhc-closer.es | SANTIAGO |